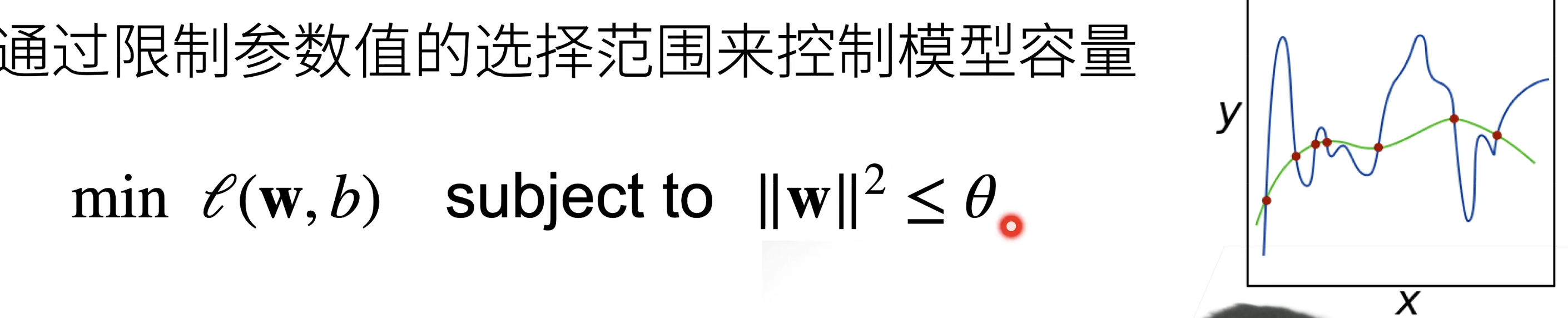

b偏移一般不限制

权重衰减(Weight Decay)确实是控制过拟合的常见方法之一。权重衰减实际上是一种正则化技术,它通过在损失函数中添加一个惩罚项来防止模型的权重变得过大,从而抑制过拟合。

权重衰减的原理

直观来说:

$\color{pink}{更常用的选下面那个函数}$:

在训练神经网络时,我们通常会最小化一个损失函数 (L(\theta)),其中 (\theta) 是模型的参数。权重衰减通过在损失函数中添加一个与权重相关的惩罚项来实现:

$$ L_{\text{total}}(\theta) = L(\theta) + \lambda \cdot \frac{1}{2} \|\theta\|^2 $$

其中:

- $L_{\text{total}}(\theta)$ 是带有权重衰减的总损失函数。

- $L(\theta)$ 是原始的损失函数。

- $\lambda$ 是权重衰减系数,控制惩罚项的强度。

- $\|\theta\|^2$ 是权重的 L2 范数(即所有权重的平方和)。

通过最小化这个总损失函数,我们不仅希望最小化原始损失,还希望让权重尽可能小。这有助于防止模型过拟合训练数据。

在 PyTorch 中使用权重衰减

在 PyTorch 中,可以通过在优化器中设置 weight_decay 参数来实现权重衰减。以下是一个示例:

import torch

from torch import nn

from torch.optim import SGD

# 定义一个简单的模型

model = nn.Sequential(

nn.Linear(10, 20),

nn.ReLU(),

nn.Linear(20, 1)

)

# 定义损失函数

criterion = nn.MSELoss()

# 定义优化器,并设置 weight_decay 参数

optimizer = SGD(model.parameters(), lr=0.01, weight_decay=0.01)

# 生成一些示例数据

inputs = torch.randn(100, 10)

targets = torch.randn(100, 1)

# 训练循环

for epoch in range(100):

optimizer.zero_grad() # 清零梯度

outputs = model(inputs) # 前向传播

loss = criterion(outputs, targets) # 计算损失

loss.backward() # 反向传播

optimizer.step() # 更新参数

if (epoch + 1) % 10 == 0:

print(f'Epoch [{epoch+1}/100], Loss: {loss.item():.4f}')

在这个示例中,我们使用了 SGD 优化器,并通过设置 weight_decay=0.01 来启用权重衰减。这样在每次更新参数时,都会对权重施加一个额外的惩罚,从而帮助控制过拟合。

权重衰减的实际效果

权重衰减的实际效果可以通过以下几点来观察:

- 减小过拟合:权重衰减通过限制模型权重的大小,防止模型过度拟合训练数据,从而提高模型在验证集上的表现。

- 平滑模型:权重衰减使得模型的参数不会过大,从而使得模型更加平滑,对输入数据的变化不那么敏感。

- 提高泛化能力:通过抑制过拟合,权重衰减可以提高模型在未见数据上的泛化能力。

总结

权重衰减是控制过拟合的有效方法之一,通过在损失函数中添加权重惩罚项,可以防止模型的权重变得过大,从而抑制过拟合。在 PyTorch 中,可以通过在优化器中设置 weight_decay 参数来实现这一点。结合其他正则化技术(如 Dropout),可以进一步提升模型的泛化能力。