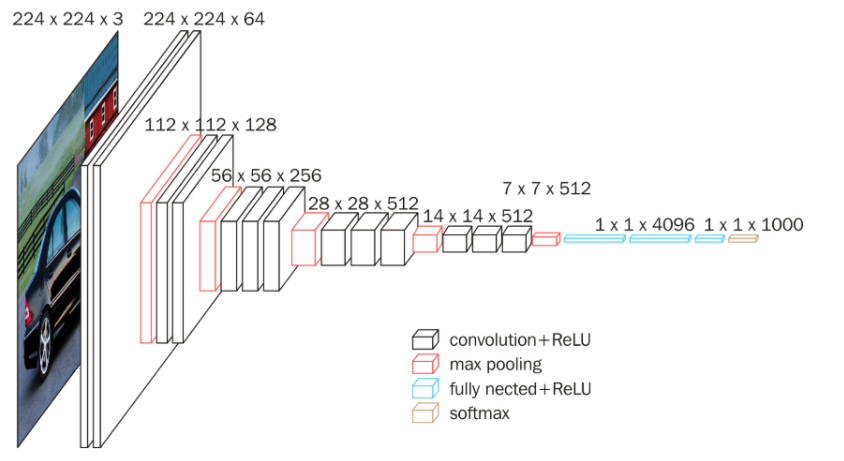

卷积层

- 首先有原图的特征,并且有一个卷积特征图(卷积图一般比原图小),卷积图在原图的每个位置上计算后生成新的特征图并移动到下一个位置(可以调整步长,调整生成特征图的大小),计算的方式是将卷积图和原图的每个数相乘后相加得到卷积后的特征图。

池化层

-

一般在卷积层之后,具有两种操作,第一种也是最常用的一种是最大特征池化(也称为下采样),同样使用一个池化特征图(图中没有数字,只有两种操作),逐渐在卷积后的特征图上移动,移动的方式可以进行调整,即可以调整池化后的大小(调整步长),之所以叫最大特征池化,是因为计算方式为在覆盖的特征图中取最大的特征,后放入到新生成的特征图中。第二种是平均特征池化,和最大特征池化相同,只是计算方式为在覆盖的特征图中取平均的特征,后放入到新生成的特征图中。

-

池化的主要目的是稳定卷积后的特征图,增强特征图中的特征,增强生成的特征图和整个网络的鲁棒性。

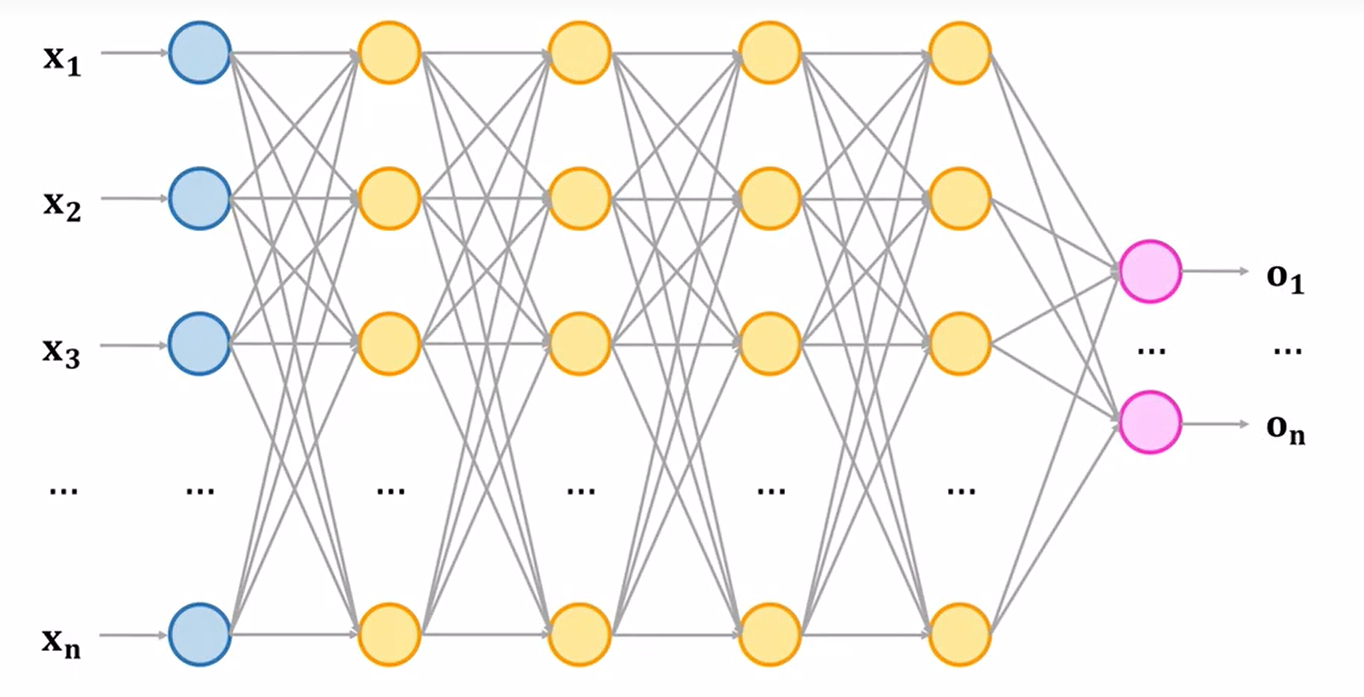

全连接层

每两层之间的所有神经元都有权重连接,通常全连接层在卷积神经网络的尾部。全连接层的主要作用是将前面层(如卷积层、池化层等)计算得到的特征进行整合。这些特征在前面的层中已经被提取和表示,全连接层通过将它们连接起来,形成一个更加紧凑和具有代表性的特征向量。

对比

如果说卷积层、池化层和激活函数层等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的“分布式特征表示”映射到样本标记空间的作用。在分类任务中,这意味着将特征向量映射到不同的类别标签上。

深度学习

- 在早期的深度学习中,一般认为神经网络越深最后的效果会越好,但是当网络层数超过20时效果却降低了,是因为所有的特征图都是基于上一层的特征图生成的,那么层数越深特征的准确度就会越低。

全连接神经网络(也称为密集连接神经网络或前馈神经网络)

- 在全连接神经网络中,每个神经元都分别和上一层的所有神经元相连接,因此每个神经元都会获取到全局信息

卷积神经网络

- 在卷积神经网络中,卷积层的每个神经元只和上一层的部分神经元相连,只感知上一层输入数据的局部区域,单个神经元只和图像中的局部像素有连接,具有较小的感受野,只能获取局部特征。

GPT(Generative Pretrained Transformer),生成式预训练Transformer,其中Transformer是一个深度学习模型

AIGC(Artificial Intelligence Generated Content),人工智能生成内容